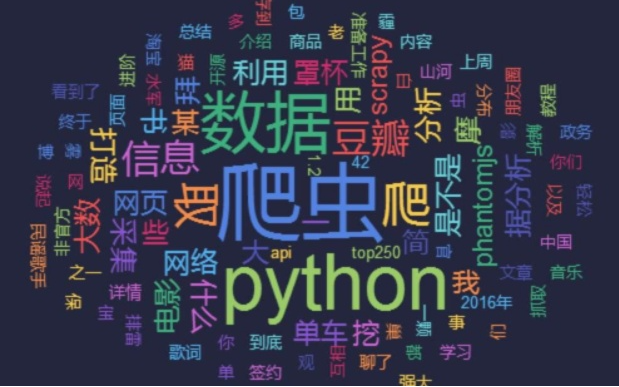

Python爬虫是怎样爬取数据的工作原理

时间:2021-07-13 14:37:27

来源:兔子IP

Python爬虫通过URL管理器,判断是否有待爬URL,如果有待爬URL,通过调度器进行传递给下载器,下载URL内容,并通过调度器传送给解析器,解析URL内容,并将价值数据和新URL列表通过调度器传递给应用程序,并输出价值信息的过程。Python爬虫常用框架有:爬虫代理推荐使用兔子IP代理。

一:grab:网络爬虫框架(基于pycurl/multicur);

二:scrapy:网络爬虫框架(基于twisted),不支持Python3;

三:pyspider:一个强大的爬虫系统;

四:cola:一个分布式爬虫框架;

五:portia:基于Scrapy的可视化爬虫;

restkit:Python的HTTP资源工具包。它可以让你轻松地访问HTTP资源,并围绕它建立的对象;

demiurge:基于PyQuery的爬虫微框架。

Python爬虫应用领域广泛,在网络爬虫领域处于霸主位置,Scrapy、Request、BeautifuSoap、urlib等框架的应用,可以实现爬行自如的功能,只要您数据抓取想法,Python爬虫均可实现!